인공지능(AI)

Supervised - Linear Regression - Gradient Descent(경사하강법)

sysman

2020. 10. 15. 11:12

1. Regression ( 수치예측)

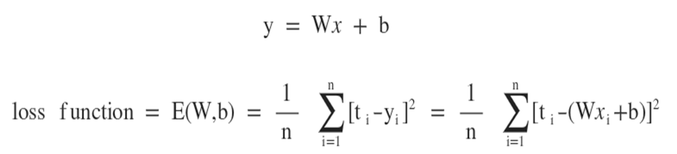

- error값의 최소값을 찾아 최적의 기울기를 찾음.

평가기준(error=loss=cost 동일 기준 개념(전부 낮아야 함))

y: 실제값, ^y:예측값

cost(loss)손실값 : (y-^y)^2

MSE : mean(y-^y)^2

learning rate(stepsize) 는 w값이 크면 발산할 수 있으므로 조금씩 W값을 이동 시키는 상수

학습원리

gradient decent : w = w-@미분(w)

출처

blog.naver.com/PostView.nhn?blogId=beyondlegend&logNo=221346376413

머신러닝 경사하강법 (Gradient Decent Algorithm)

선형회귀(Regression)에서 가중치 W, 바이어스 b 를 찾는 알고리즘인 경사하강법(Gradient Decent Alg...

blog.naver.com

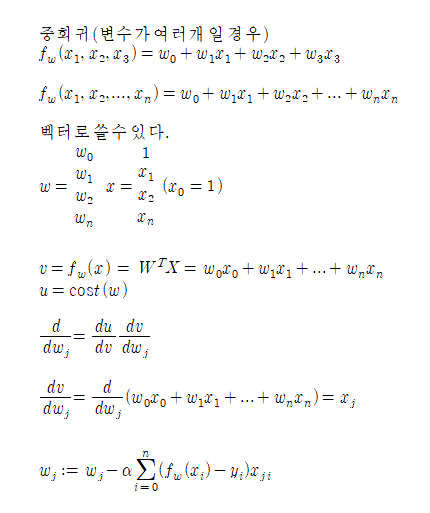

<정리>

local minimum일 때 Mini-batch 법 사용(랜덤한 값의 집합을 사용하여 최소값을 찾음)

K를 집합으로 만들고 랜덤한 값을 잡아서 찾는다.

K={10, 21, 38, 45, 52}